段小草的回答

昨天已经回答过这个话题,今天再聊几个我看到的比较典型的看法吧。

1、开源不就是让别人抄吗?

这种话属实有点可笑了,一句话回答:开源并不意味着放弃权利。具体来说:

开源的核心理念是共享与协作。是为了通过开源实现相互学习、共同进步,从而推动整个领域的发展,加速技术的普及和创新。开源有很多好处,比如通过社区构建开发生态(比如谷歌的 TensorFlow 和 Meta 的 PyTorch 这两个深度学习框架),通过共同研究发现潜在的安全问题,让更多技术人员参与到代码和模型的审查中。

但是,开源并不意味着放弃所有权或控制权。开源项目采用了各种开源许可证(如MIT、Apache、GPL等),可以在一定程度上保护原作者的权益,同时允许他人使用和改进代码。

2、MiniCPM-Llama3-V 2.5 不也抄 Llama 了吗?名字里都写着呢。

MiniCPM-Llama3-V 2.5 [1]恰恰是开源社区的正面例子,从一开始 MiniCPM-Llama3-V 2.5 就说自己是基于 SigLip-400M 和 Llama3-8B-Instruct 构建的多模态模型,注意 Llama 是语言模型,而 MiniCPM-V 是视觉多模态模型。

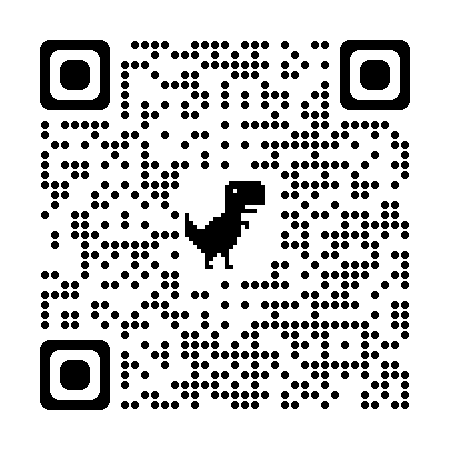

可以说,MiniCPM-Llama3-V 2.5 继承了 Llama 模型的多语言能力,新增并优化了多模态理解能力,在端侧设备上也能展现出强大的多模态交互能力。感兴趣可以到 HuggingFace 上在线体验一下[2]。(我上传了一张单片机的图片,这是它的回答)

也可以尝试自己部署:openbmb/MiniCPM-Llama3-V-2_5 · Hugging Face

类似的观点下,也有人提到了零一万物和 Llama 的关系。不妨直接放出来 01 自己的解释[3]:

Yi系列模型采用与Llama相同的模型架构,但它们并不是Llama的衍生品。

Yi和Llama都基于自2018年以来作为大语言模型标准架构的Transformer结构。

Llama因其卓越的稳定性、可靠的收敛性和强大的兼容性,成为了大多数先进开源模型的基石。它被广泛接受为包括Yi在内的许多模型的基础框架。

借助Transformer和Llama架构,其他模型能够利用这些强大的功能,减少从头构建的复杂性,并在其生态系统中使用相同的工具。

然而,Yi系列模型并不是Llama的衍生品,因为它们没有使用Llama的权重(weights)。

虽然Llama的结构被大多数开源模型所采用,但决定模型性能的关键因素在于训练数据集、训练流程和训练基础设施。

Yi通过独特和专有的方式开发,独立创建了高质量的训练数据集、高效的训练流程和强大的训练基础设施。这一努力使得Yi系列模型表现出色,在2023年12月的Alpaca排行榜上,Yi系列模型排名仅次于GPT-4,超越了Llama。

3、不过是几个本科生罢了,至于上纲上线吗?

咋说呢,是非曲直,立正挨打。若只是本科生的什么课程作业也就罢了,但看看这几位的做法。Github 开源、HuggingFace 开源,Medium + 推特高调宣发,被人指出错误以后,先是嘴硬,最后被实锤了才甩锅+删库跑路。总不能宣发的时候背靠学校和机构,出事的时候就光速切割吧。

我不觉得有什么好洗的。也许在一些人眼里,承认中国团队的优秀挺难的。但好在是非曲直,公道人心,还是那句话,喧嚣过后,继续向前。